中国尚未直接感受到中东战争的冲击——至少目前还没有。

但是它已经感受到战争的涟漪。

短期而言,中国仍有足够的石油供应,可支撑数月,之后还能向邻国俄罗斯寻求支援。

然而,中国正在计算的是,这对长期前景意味着什么——不仅关乎其在中东的投资,也关乎其整体战略雄心。

本周,数千名中国共产党代表在北京开会,讨论这个全球第二大经济体的发展路线图。中国仍在对抗低迷的内需、持续的房地产危机和庞大的地方债务。

周四(3月5日),中国把年度经济增长目标下调至1991年以来的最低,尽管北京仍在快速推动发展高科技和可再生能源产业。

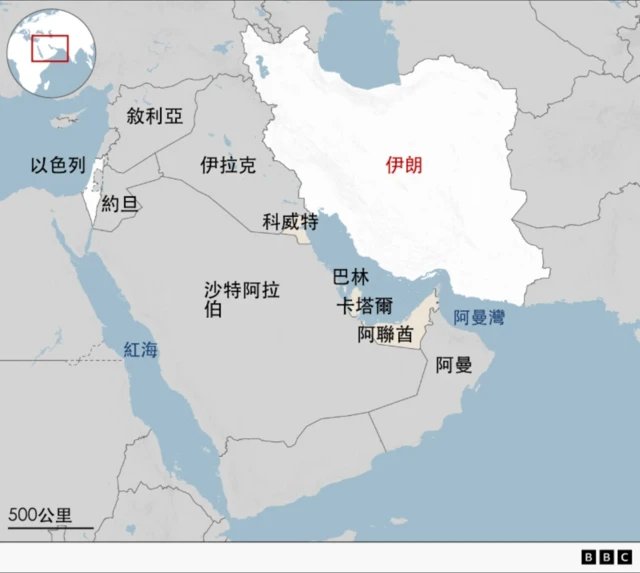

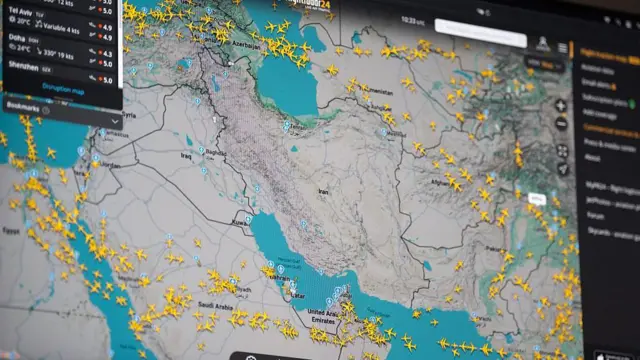

中国或许希望透过出口走出经济困境,但是它过去一年一直在和美国打贸易战,如今又面临中东动荡的前景——该地区既提供中国的主要航运路线,也提供大量能源。

战事拖得越久,冲击就越大,特别是在霍尔木兹海峡(Strait of Hormuz)航道持续受阻的情况下。

End of 热读

“中东若长期动荡不安,将扰乱中国在其他重要地区的布局。”皇家联合军种研究所(RUSI)的菲利普・谢特勒–琼斯(Philip Shetler-Jones)表示。

“以非洲经济体为例,过去受惠于来自海湾地区的稳定资本流入;如果资金潮退去,恐怕会引发更广泛的不稳定,进而削弱中国更广、更长期利益的可持续性。”

换言之,考虑到中国的全球足迹,它在中东以外的投资和市场也同样容易受到一场旷日持久的战争波及。和许多国家一样,中国也对这波新的不可预测性心存戒心。

“我想中国的想法跟所有人一样。”伦敦国王学院刘氏中国研究所(The Lau China Institute)所长凯瑞・布朗(Kerry Brown)说。

“计划是什么?美国总不可能毫无计划就介入吧。”

但是,他又补充:“也许又和大家的直觉一样,他们会想:天啊,他们真的毫无计划。好吧,我们不想被卷入,就像不想被卷入其他任何事一样,但我们同时也得做点什么。”

不坚固的盟友

在西方,很多人一直认定伊朗是中国的“盟友”。

两国确实长期保持友好关系。德黑兰最高领袖阿里・哈梅内伊(Ali Khamenei)在 1989年最后一次的对外出访就是北京,还在长城前留影。

习近平在2016年造访德黑兰后,双边关系更进一步;两国最终在2021年签署为期25年的战略伙伴关系协议。

中国承诺25年内在伊朗投资4000亿美元(约3000亿英镑),作为交换,伊朗将维持稳定供油。

然而,分析人士认为,只有一小部分资金真正到位,但原油供应仍持续不断。

哥伦比亚大学全球能源政策中心(Center on Global Energy Policy)估算,2025年中国从伊朗进口原油日均138万桶,约占中国原油总进口12%。其中很多货物产地被指重新标示为“马来西亚”以掩饰来源。

该中心的研究还指出,亚洲海上浮动库存中有超过4600万桶伊朗原油;此外,在中国大连和舟山港口的保税仓也囤有更多尚未通关的原油——而那里是伊朗国家石油公司(National Iranian Oil Company)租用油槽的地方。

两国之间还传出军火交易的指控。中国否认向德黑兰出售反舰巡弋导弹,但美国情报界指控北京透过培训工程师和供应零部件,支持伊朗的弹道导弹计划。

人权团体则称,伊朗对抗议者和政权批评者的严厉镇压,部分仰赖来自北京分享的人脸识别和监控技术。

种种迹象让两国看似关系紧密。

这甚至促使小报以“动荡轴心”(axix of upheaval)将中国和伊朗归为一类,加上朝鲜与俄罗斯。四者确实都意在挑战美国主导的国际秩序,但实际上它们彼此的关系更接近交易导向。

“中国和伊朗没有真正的意识形态或文化连结。”凯瑞・布朗说。

“中国近似采取‘分而治之’的策略,有时因伊朗成为美国的长期扰动因素而受益。因此,中国想和伊朗维持关系,多半是出于消极而非积极的理由。”

“这对关系的基础非常脆弱;它确实在某种程度上奏效,但并不深厚。”

中国对“盟友”的理解和西方不同:它不签共同防御条约,也不会在盟友遭攻击时立即出手。

相反,北京竭力避开任何冲突。

谁是领袖

但这不代表它对中东局势不感到忧虑。

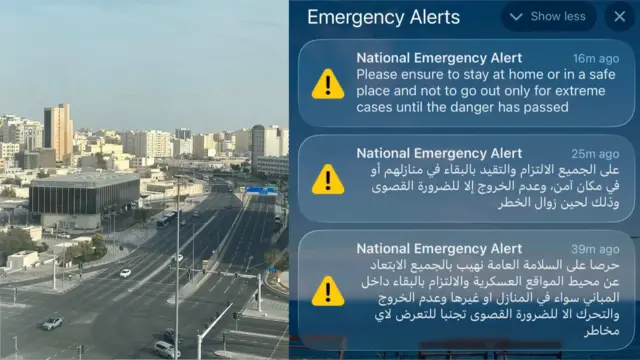

北京发出了可预期、语气克制的谴责,并呼吁停火。

中国外长王毅表示,美国与以色列对伊朗发动攻击并“公然击杀一个主权国家领导人,鼓动政权更迭,不可接受”。

实际上,美国1月份在委内瑞拉的行动,以及如今在伊朗的作为,正凸显了这些国家与中国伙伴关系的局限。

两次事件中,北京都留在场边作为旁观者,无力援助其“势力范围”内的伙伴。

皇家联合军种研究所的菲利普・谢特勒–琼斯认为,中国正试图把自己定位美国的“负责任的制衡力量”,但“就军事力量而言,美国正在示范何为‘超级强权’——能在全球战区强行塑造结果的能力”。

他主张,尽管中国经济实力雄厚,但尚不是与美国“同级的超级强国”;“即便愿意,中国也没有能力保护其朋友免于这类行动。”

为了回应这些疑虑,习近平将持续把自己塑造成稳定、可预测的全球领袖,以形成与特朗普的对比。

伦敦大学亚非学院(SOAS)中国研究院院长曾锐生(Steve Tsang)表示:“中国会主张,特朗普再次毫无疑问地揭示了西方及其宣称的自由国际秩序有多麽伪善。”

他补充称,因冲突导致的能源供应和航空旅行中断,将在经济上对“全球南方”造成远大于西方的影响。

“几个月内,部分国家将出现粮食短缺……而这些正是全球南方国家。我们也看到西方同盟出现裂缝,英国、西班牙被单独点名为攻击对象。”

北京或许也看到和其他国家一道牵线调停的机会。王毅已经和阿曼及法国外长通话,中国还宣布将派特使前往中东。

特朗普访华在即

只不过,中国仍然小心翼翼——其中一个最大变数是多变的美国总统特朗普,他预计于本月稍晚进行备受瞩目的访问会晤。

值得注意的是,中国对美以针对伊朗的打击之批评,未直接点名特朗普,这可能让此次握手更容易成行。

外界曾猜测访问是否还能进行,但目前迹象显示行程仍在规划中。据路透社报导,双方官员将开会讨论行程。

谢特勒–琼斯指出,中国也可能藉此“观察风向”,了解特朗普将如何回应其他潜在引爆点,例如中国宣称拥有主权但实施自治的台湾。

“这场战争的不受欢迎,可能会推动美国外交安全政策走向‘克制’——如果未来的政府将其付诸实行,就会让中国在其所在区域及更广泛世界追求自身利益时拥有了更大空间。”

这场危机为中国某些舆论提供了将华盛顿描绘为好战分子的题材。中国解放军也在社交媒体上作出类似的定调。

但凯瑞・布朗认为,有这样一个“不可预测且功能失调的行动者”,同样会令北京不安。

“我不认为中国想要一个由美国主导的世界,但它也不会真的想要一个美国行为如此不稳定的世界。”